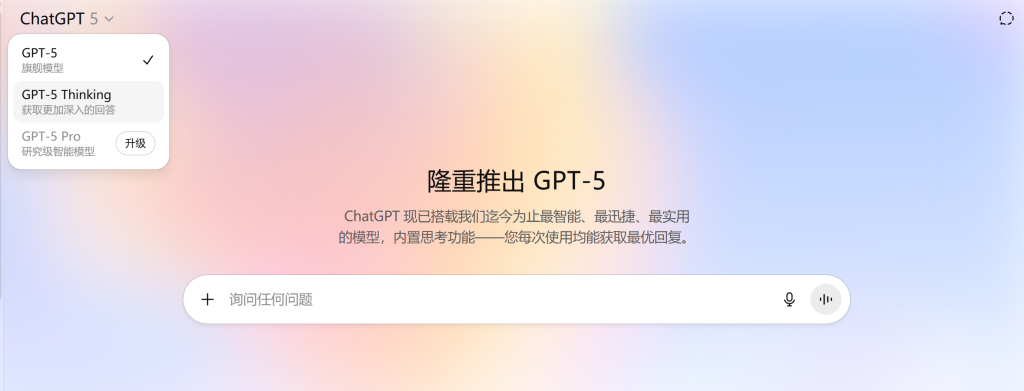

一、GPT-5 是什么

GPT-5 是 OpenAI 的最新一代通用大型模型家族。与以往按场景区分多个模型不同,GPT-5 采用统一的集成式架构,并由路由系统在后台自动选择最合适的子路径(例如快速响应或深度推理),用户不需要手动切换模型。整体目标是提供更可靠的专业级助手体验,同时保持使用门槛尽可能低。

- 统一路由:根据任务需求在“主模型”和“深度思考(thinking)”路径之间自动选择,平衡速度、成本与质量。

- 多模态原生:在文本、代码、图像等多模态任务上具备更强的理解与生成能力。

- 事实性与稳健性提升:对错误与幻觉显著抑制,适合知识密集型任务与面向客户的生产应用。

二、主要功能与特性

- 更强的代码能力:在真实代码基准(如 SWE-bench Verified)上达到最新水平,能阅读大型代码库、解释复杂逻辑并生成可运行补丁。

- 高水平数学推理:在数学竞赛类测试中表现显著提升,适合涉及计算、证明与推导的任务。

- 多模态理解与工具协同:可处理图表、公式与界面截图等,并与检索、执行器、函数调用等外部工具配合。

- 自动“思考”模式:在高难度任务下延长推理步数,提高正确率;在简单任务时保持快速响应。

- 更长上下文:更大上下文窗口(官方资料显示大幅扩展),利于长文档总结、长对话与跨文件代码分析。

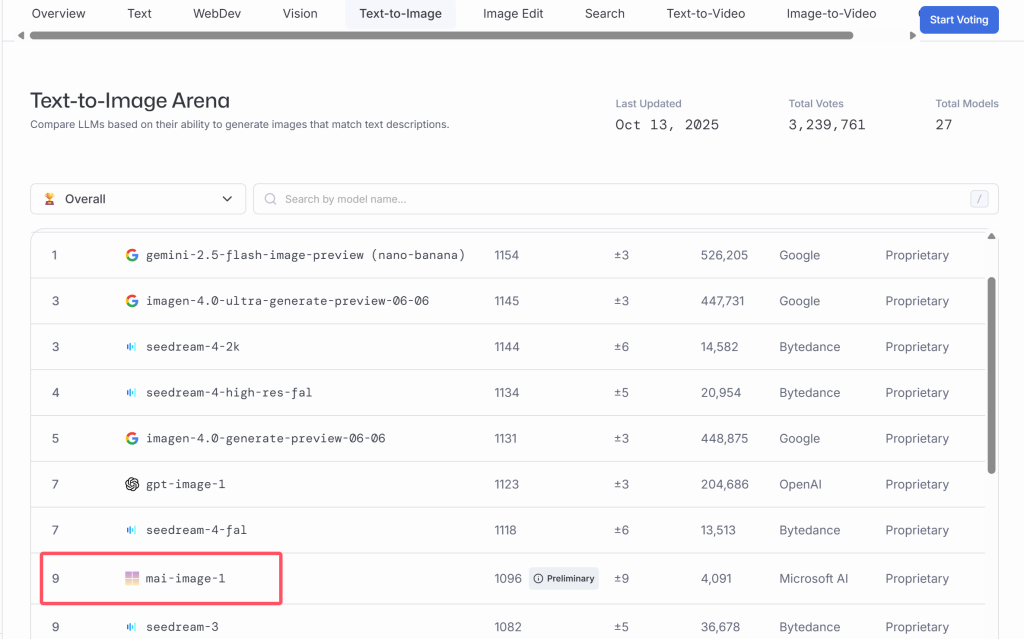

三、性能表现(基准与要点)

以下为 GPT-5 官方与第三方渠道公开的代表性指标(不同设置可能导致数值有差异,建议以官方页面为准):

- 数学(AIME 2025):无工具条件下约 94.6%。

- 真实编程(SWE-bench Verified):约 74.9% 通过率。

- 多模态理解(MMMU):显著优于上一代通用模型。

- 事实性:在 LongFact、FActScore 等评测中错误率较上一代明显降低。

这些提升不仅体现在基准分数,更在日常使用中的稳定性、可控性与结果质量上带来可感知的改进。

四、版本信息与定价

GPT-5 为一个模型家族,覆盖不同的性能与成本区间,便于按照业务目标做取舍。以下为目前公开的典型形态与 API 价格(以官方定价为准):

| 版本 | 定位 | 输入计费(每百万 tokens) | 输出计费(每百万 tokens) | 适用场景 |

|---|---|---|---|---|

| GPT-5 | 旗舰模型(深度推理与企业工作流) | $1.25 | $10.00 | 复杂推理、代码协作、智能体、重要业务流程 |

| GPT-5 Mini | 加速与降本版本(明确任务) | $0.25 | $2.00 | 高并发、响应速度优先、成本敏感型应用 |

| GPT-5 Nano | 极致性价比与轻量推理 | $0.05 | $0.40 | 大规模批处理、轻量对话、模板化生成 |

说明:如有“缓存输入”优惠价、上下文窗口规格等细节,请以官方 API Pricing 页面为准。

五、如何使用(ChatGPT 与 API)

1. 通过 ChatGPT 使用

登录 ChatGPT,即可默认使用新一代体验。面向免费用户与付费用户逐步开放。

- 访问官网:访问GPT-5的官网ChatGPT。

- 免费用户:

- 访问方式:GPT-5 已全局上线,免费用户能直接在 ChatGPT 中使用。

- 限制:免费用户的 GPT-5 用量会明显受限。当用量耗尽后,模型会被切换成 GPT-5 mini。

- Plus 用户:Plus 用户有更高的 GPT-5 使用额度。

- 额外功能:Plus 用户能在 Codex CLI 中使用 GPT-5,开启“思考模式”。

- Pro 用户:Pro 用户能无限制访问 GPT-5,可使用 GPT-5 Pro。

- 功能:Pro 用户能访问所有 GPT-5 的功能,包括高级的编程和创作工具。

2. 通过 OpenAI API 使用

开发者可直接调用 API 接入 GPT-5 家族。

- API 调用方法:

- 支持的模型:API 中支持的 GPT-5 模型包括 gpt-5、gpt-5-mini、gpt-5-nano 和 gpt-5-chat。

- 输入输出:支持用图文输入,并用文字输出。

- Endpoint:支持 /chat/completions、/responses 和 /assistants 等 endpoint。

- 功能支持:

- Streaming:支持流式输出。

- Function calling:支持函数调用。

- Structured outputs:支持结构化输出。

- 微调:支持模型微调。

- Responses API:支持 Web search、File search、Code interpreter 和 MCP 等功能。

集成要点:

- 模型选择:若对延迟与成本敏感,先尝试 GPT-5 Mini 或 Nano;关键路径、复杂推理选 GPT-5。

- 令牌预算:控制输入与输出长度;必要时开启缓存输入(若适用)以降低成本。

- 提示工程:提供清晰任务描述、输入格式与验收标准;复杂流程可拆分多步与函数调用。

- 评测与回归:将业务样本转为基准测试集,持续对比不同版本、不同温度与不同上下文策略。

- 安全与合规:遵循隐私政策与内容安全规范;对面向用户的输出增加审核与日志。

六、应用示例(可直接借鉴)

1. 代码助手与缺陷修复

将代码片段与报错粘贴给模型,请求定位缺陷与补丁建议;在 CI 中接入自动审阅,先由模型给出候选改动,再由工程师复核合并。

2. 文档理解与知识总结

为长篇技术文档与会议纪要生成结构化摘要、行动清单与时间线;在知识库检索后,由模型统一口径输出回答。

3. 数据分析与报表草稿

在提供字段解释与示例数据后,请求模型生成分析思路、SQL 草稿与可视化建议,人工确认后进入 BI 流程。

4. 客服与运营问答

结合 FAQ 与工单语料,构建半自动问答;高置信度自动回复,低置信度转人工,并记录模型置信度与命中知识点。

5. 教学与训练题生成

按难度梯度生成题目与讲解;对学生答案进行逐步点评与重练建议,注意对事实与公式进行抽样校验。

七、常见问题

是否需要手动选择“深度推理”模式?

通常不需要。GPT-5 的统一路由会根据任务类型自动切换;若 API 侧提供相关参数,可按业务策略显式控制。

与上一代模型相比,最大的变化是什么?

一是统一路由降低了使用门槛,二是推理与事实性显著增强,三是代码与数学等硬核任务的可用性更强。

如何控制成本?

选择合适的版本(Mini/Nano)、裁剪输入上下文、启用缓存输入(若可用)、降低温度并限制输出长度。

是否支持多模态?

支持。可在图像、文本等多模态任务中进行理解与生成;复杂流程可结合检索与工具使用。