随着 AIGC 与多模态智能的快速发展,越来越多的 AI 模型尝试打破“图像”和“语言”的界限,构建具备跨模态理解与推理能力的通用智能体。MirageLSD 就是其中一款备受关注的新兴多模态语言模型。

MirageLSD 简介

MirageLSD 是一款融合语言建模与视觉输入的多模态模型框架。它致力于实现轻量级的跨模态推理能力,支持图像、文本等不同模态的信息联合处理。其目标是在有限算力条件下,提供稳定、高效的多模态生成与理解能力。

该模型由研究机构或开源社区开发(如 LMFlow、Hugging Face 等),主要面向研究者、开发者以及多模态 AI 应用探索者。

官方网址:https://about.decart.ai/publications/mirage

核心能力与技术特点

| 功能模块 | 说明 |

|---|---|

| 图像编码 | 将视觉输入通过视觉编码器(如 CLIP 或 ViT)转化为 token 嵌入,供语言模型使用 |

| 多模态融合 | 实现图文联合训练,使模型具备视觉问答、图文生成等多模态能力 |

| 轻量级推理 | 支持小规模部署与快速响应,适用于边缘设备或开发调试 |

| 开放性架构 | 提供开源代码与模型权重,便于用户定制训练和模型微调 |

应用场景示例

- 视觉问答(VQA):用户上传一张图像,模型根据图像内容回答问题

- 图文生成:根据图片生成自然语言描述(captioning)或短文

- 多模态检索:将图片与文本相互编码,实现跨模态检索功能

- 教育与辅助应用:在教学辅助、盲人图文解读等领域具有潜力

部署与使用方式

MirageLSD 支持 Hugging Face Transformers 或 PyTorch 生态,通过如下方式启动:

- 下载模型权重并安装依赖环境

- 使用 CLI 或 API 接口进行图像 + 文本输入

- 支持多语言提示词与图文融合能力

部分社区实现还支持 Web UI,可视化输入输出过程。

MirageLSD 原理与技术优势解析

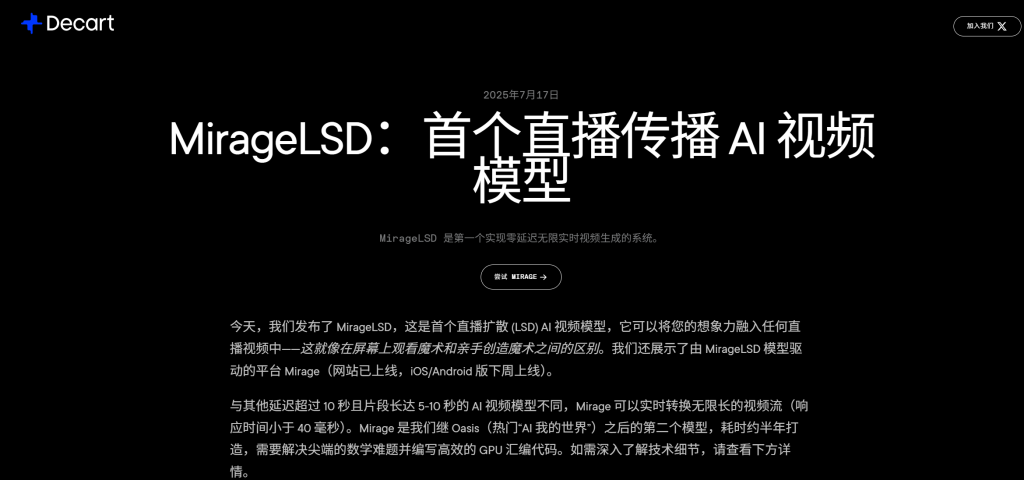

MirageLSD 是首个支持“无限生成、零延迟、实时交互”的视频扩散模型,核心基于 Decart 自研的 Live‑Stream Diffusion(LSD) 架构,可对任意直播视频流进行即时风格转换与内容生成,响应时间控制在 40ms 以下,实现流畅的 24 FPS 实时体验。

🔁 原理机制

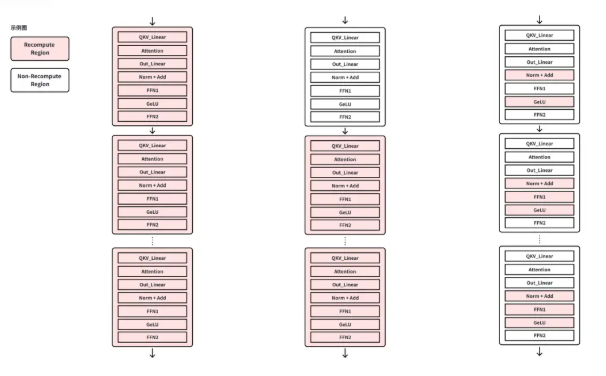

- 即时逐帧生成 + 因果结构:每一帧只依赖先前帧与用户提示,通过因果自回归保持时间一致性,无需缓冲大段视频。

- Diffusion Forcing + 历史数据增强:在训练中人为加入噪声,增强模型对历史帧瑕疵的鲁棒性,抵消误差积累问题,实现“无限长”输出稳定性。

- 无限生成能力:结合 Diffusion Forcing 与历史增强,使 LSD 模型可持续生成视频而不崩溃。

- 超低延迟:专用 CUDA mega kernels、结构感知剪枝与 shortcut distillation,使每帧生成时间低至40ms,实现实时交互。

- 时间一致性:因果反馈循环确保视频风格、场景与用户提示始终保持同步,不会出现“抖动”或“风格漂移”。

- 端到端优化设计:在 Hopper GPU 架构上定制 mega kernel,结合稀疏剪枝与蒸馏技术,整体性能提升达16倍。

✅ 与传统视频生成模型对比优势

- 无需事先生成短片或等待缓冲,具备真·实时“零延迟”生成能力。

- 支持无限流式生成,不会因误差积累而导致质量崩溃。

- 具备交互式编辑能力,可边看边变、边提示边生成,适用于直播增强类应用。

- 专为现代显卡设计,算法与系统协同优化,兼具高质量与高效性能。

总结

MirageLSD 是当前多模态 AI 领域的一项值得关注的轻量级框架。它在保持高性能表现的同时,降低了使用门槛,非常适合用作研究探索、教育实验、产品原型等多种场景。