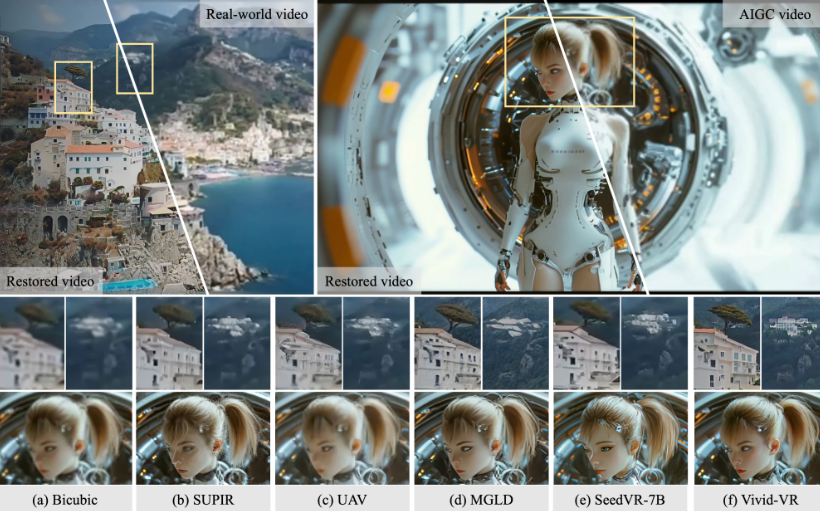

在生成式AI技术飞速发展的浪潮下,视频修复领域迎来了革命性突破。阿里云最新开源的 Vivid-VR,一款基于生成式AI的视频修复工具,凭借其出色的帧间一致性和修复效果,正迅速成为内容创作者和开发者社区的关注焦点。

Vivid-VR:AI驱动的视频修复新高度

Vivid-VR 是阿里云推出的一款功能强大的开源工具,它利用先进的文本到视频(T2V)基础模型,并融合了 ControlNet 技术。这种创新架构确保了修复过程中的内容高度一致性,有效解决了传统视频修复中常见的闪烁、抖动等问题。

无论是修复低质量的真实视频,还是优化AI生成的(AIGC)视频,Vivid-VR 都展现了卓越的性能,为内容创作者提供了高效、智能的素材补救方案。

技术核心:T2V与ControlNet的完美融合

Vivid-VR 的核心优势在于其独特的复合技术架构。T2V 模型负责生成高质量的视频内容,而 ControlNet 则作为精准的控制机制,确保修复后的每一帧在时间维度上保持高度连贯。

在生成过程中,该工具能够动态调整语义特征,显著提升视频的纹理真实感和视觉生动性。这种技术组合不仅提高了修复效率,更保证了视频内容的稳定性和观感。

广泛适用性:全面覆盖真实与AIGC视频

Vivid-VR 的另一大亮点是其广泛的适用性。它不仅能修复传统相机拍摄的真实视频,也能够优化由AI生成的视频。这对于内容创作者来说,无疑是巨大的福音。

无论是短视频制作、影视后期,还是创意内容产出,Vivid-VR 都能通过智能分析和增强,快速修复模糊、噪点或不连贯的视频片段。此外,该工具支持多种输入格式,并允许开发者灵活调整参数,进一步提升创作效率。

开源生态:赋能全球创作者与开发者

作为阿里云在生成式AI领域的又一力作,Vivid-VR 已完全开源,代码和模型可在 Hugging Face、GitHub 以及 阿里云的 ModelScope 平台上免费获取。

这一举措延续了阿里云在开源社区的领先地位,也进一步降低了技术门槛,让更多人能够基于这一工具开发定制化的视频修复应用。此前,阿里云的 Wan2.1 系列模型已位居 VBench 视频生成模型榜首,Vivid-VR 的开源无疑将为社区注入新的活力。

总结:推动内容创作的智能化升级

在视频内容主导数字传播的今天,Vivid-VR 的出现为创作者提供了一个高效、低成本的解决方案。它不仅能解决视频质量的实际痛点,还将通过开源生态激发更多创新应用。

我们相信,Vivid-VR 将助力全球内容创作者提升作品质量,并推动视频修复领域的智能化革新,为行业带来新的增长点。